import pandas as pd

import numpy as np

import nltk;

nltk.download('punkt')

nltk.download('averaged_perceptron_tagger')

nltk.download('wordnet')

nltk.download('stopwords')

import matplotlib.pyplot as plt

%matplotlib inline

import nltk

from nltk import word_tokenize, sent_tokenize

from nltk.corpus import stopwords

from nltk.stem import LancasterStemmer, WordNetLemmatizer, PorterStemmer

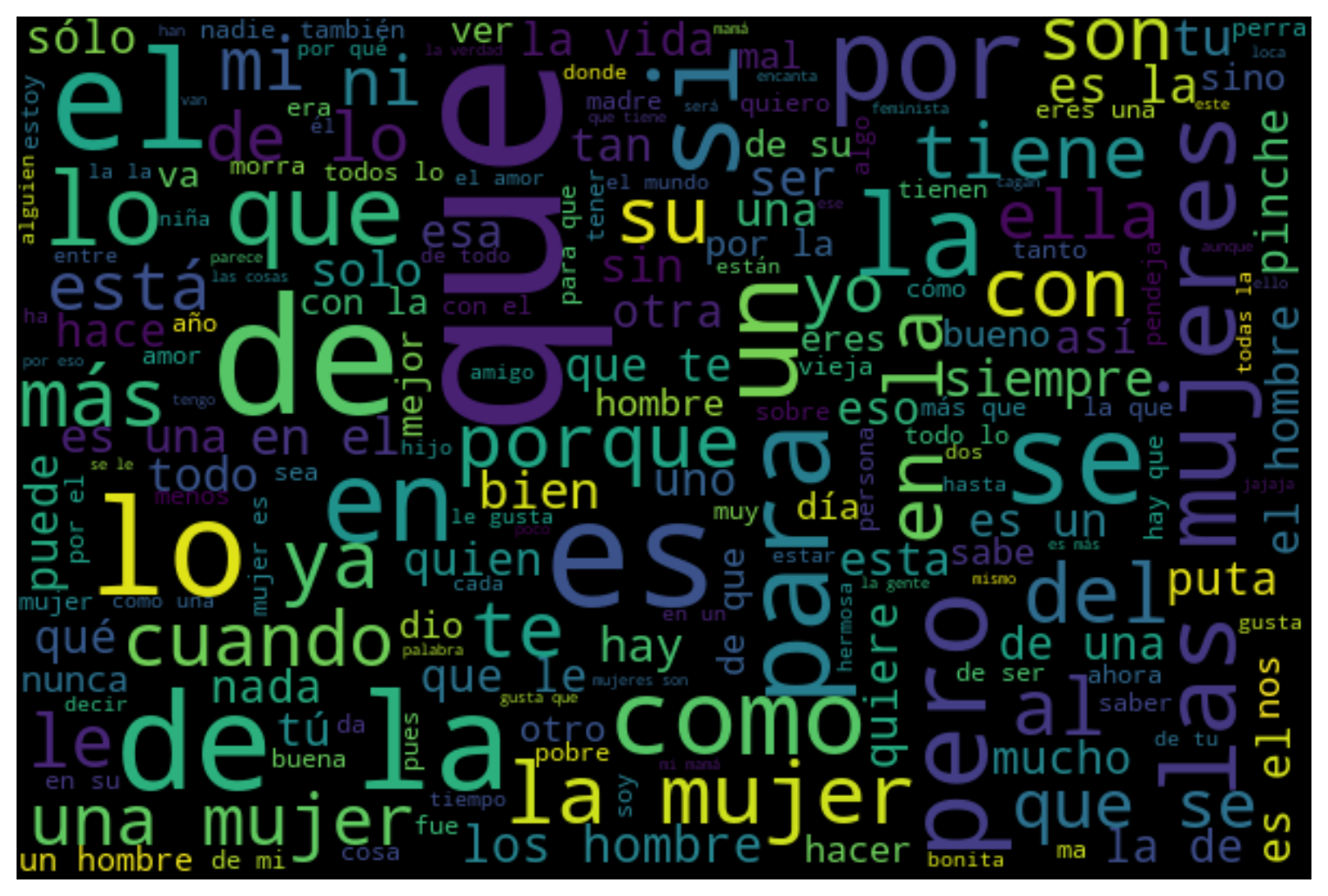

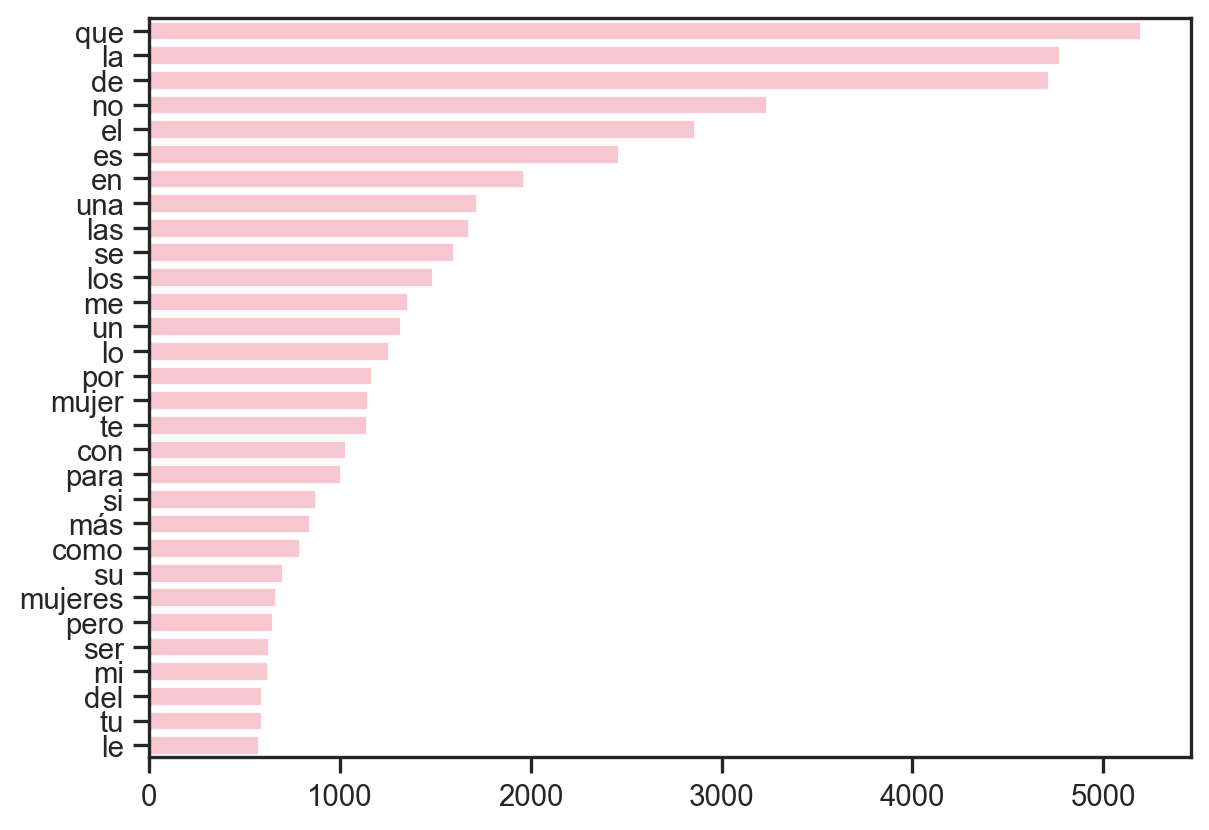

from wordcloud import WordCloud, STOPWORDS

from textblob import TextBlob

from nltk.sentiment import SentimentIntensityAnalyzer[nltk_data] Downloading package punkt to

[nltk_data] C:\Users\valer\AppData\Roaming\nltk_data...

[nltk_data] Package punkt is already up-to-date!

[nltk_data] Downloading package averaged_perceptron_tagger to

[nltk_data] C:\Users\valer\AppData\Roaming\nltk_data...

[nltk_data] Package averaged_perceptron_tagger is already up-to-

[nltk_data] date!

[nltk_data] Downloading package wordnet to

[nltk_data] C:\Users\valer\AppData\Roaming\nltk_data...

[nltk_data] Package wordnet is already up-to-date!

[nltk_data] Downloading package stopwords to

[nltk_data] C:\Users\valer\AppData\Roaming\nltk_data...

[nltk_data] Package stopwords is already up-to-date!